En remplaçant la logique classique 0/1 des processeurs actuels (les bits) par celle des qubits (les bits quantiques) fondés sur la superposition et l’intrication, on obtient en théorie une « machine quantique universelle » capable de réduire considérablement le temps d’exécution de certains algorithmes (problèmes d’optimisation, apprentissage automatique, méthodes de cryptographie…).

Le double défi du calcul et de l’informatique quantique est d’une part de disposer d’un grand nombre de qubits « physiques » robustes à la décohérence, d’autre part de concevoir l’architecture et les protocoles pour les utiliser le plus efficacement possible. Les qubits peuvent être réalisés à partir de systèmes physiques très variés (ions, photons, atomes froids, supraconducteurs, semi-conducteurs), la difficulté étant de les piloter rapidement sans que des perturbations extérieures ne puissent réduire considérablement la fidélité du calcul.

Plusieurs modèles de calcul quantique ont été développés ainsi que des stratégies d’encodage d’information permettant la correction des erreurs grâce à une redondance, un qubit logique étant représenté par plusieurs qubits physiques. Ainsi, la construction d’un ordinateur quantique est un effort interdisciplinaire mêlant physique, mathématiques appliquées, informatique et instrumentation.

A l’heure actuelle, les premières machines dites « Noisy Intermediate-Scale Quantum » (NISQ), du type de celles mises en oeuvre par Google ou IBM, utilisent un nombre modéré de qubits imparfaitement contrôlés (portes fidèles à 1 % près). Elles nécessitent une optimisation de l’architecture spécifique à la plateforme physique. L’analyse de l’algorithmique associée à ces machines imparfaites inspire en retour de nouvelles idées de simulation classique. A plus long terme, la réalisation d’un ordinateur quantique universel de grande taille et effectuant des calculs longs nécessitera d’introduire la correction des erreurs. Ces techniques requièrent une fidélité des portes sur la plateforme de base supérieure à 99 % et sont complexes et gourmandes en ressources, ce qui rend très précieuse toute simplification des architectures existantes. Pour la programmation de ces machines universelles, si certains algorithmes comme le « Quantum Approximate Optimization Algorithm » (QAOA) se sont imposés, beaucoup n’ont pas encore de preuve complète d’accélération quantique et d’autres restent sans doute à découvrir. La caractérisation des possibilités et des limites fondamentales du calculateur quantique idéal est donc un domaine de recherche très actif.

Les laboratoires franciliens contribuent à tous les niveaux de cette quête par d’excellents travaux de recherche fondamentale (Figure 1). Dans leur prolongement, des startups récentes comme Alice & Bob, lancées au cours du DIM SIRTEQ (2017-2021), deviennent viables et annoncent l’ordinateur quantique comme finalité.

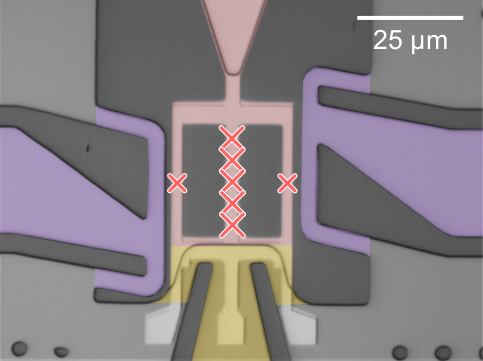

Figure 1 : Dispositif supraconducteur permettant d’améliorer les performances des qubits et à terme de réduire les erreurs.

Objectif

L’objectif de l’axe est de stimuler la recherche en Île-de-France autour de l’ordinateur quantique universel, tant du point de vue expérimental (plateformes physiques pour la machine) que théorique (correction des erreurs, algorithmes pour un ordinateur idéal ou imparfait).

Responsables

Patrice BERTET

SPEC, CEA SaclayAlain SARLETTE

INRIA Paris

Bureau

Thierry LAHAYE

LCFValentina PARIGI

LKBFrédéric MAGNIEZ

IRIFThomas AYRAL

EVIDEN